|

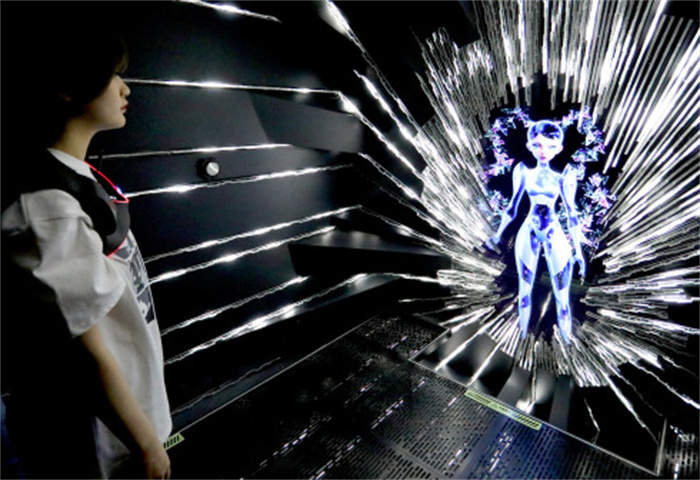

| 4月12日,體驗者在“AI之夢”項目中進行互動體驗。(來源:新華社) |

中評社香港5月28日電/據大公報報導,運用深度學習演算法訓練生成式人工智能(GenAI)的大語言模型近年備受關注。香港理工大學最近一項研究發現,如果以人類處理語言的類似方式進行訓練,大語言模型理解語言的表現就更像人類腦部。領導該研究的理大人文學院院長李平表示,此項研究解釋了如何利用大語言模型研究人類大腦加工語言的高級機制,還能促進人工智能和認知神經科學領域研究人員之間的互動與合作,推動未來相關研究。

現有的大語言模型主要依賴於上下文單詞預測單一類型的訓練。近期研究亦表明,大語言模型中的單詞預測可以作為人類處理語言的認知模型。然而,人類平時理解語言時不僅只會預測下一個單詞,還會整合自然語言理解中的高層次信息。

理大人文學院院長兼冼為堅基金人文與科技講座教授李平領導的研究團隊,將模擬人腦評估句子之連貫性的“下一句子預測”(Next Sentence Prediction,NSP)納入模型預訓練,並檢驗模型數據與腦活動的相關性。研究發現NSP能用來預測前後句子怎樣互相關聯,與人類語義理解的神經模型非常脗合,亦能強化大語言模型的能力。

與只學習單詞預測的模型相比,NSP增強模型與腦數據在多個腦區顯示出更一致。研究結果亦提供了新見解,瞭解人類大腦如何加工語義,包括右腦在理解語義中的重要作用。其他發現亦顯示大語言模型納入NSP的優勢,即基於增強模型的“模型─腦對應”分數可以更好地預測人的閱讀速度。

近期如ChatGPT的大語言模型主要通過無限擴充訓練資料和模型規模以提升能力。李平表示,僅依靠這種極度擴展的方式存在很多局限,新的突破則有賴於我們將大模型變得更像人腦那樣不需要海量數據,更高效益。他亦指出,像NSP這類多樣化的學習任務可以改進大語言模型的人性化水準,使其更加接近人類智慧。 |